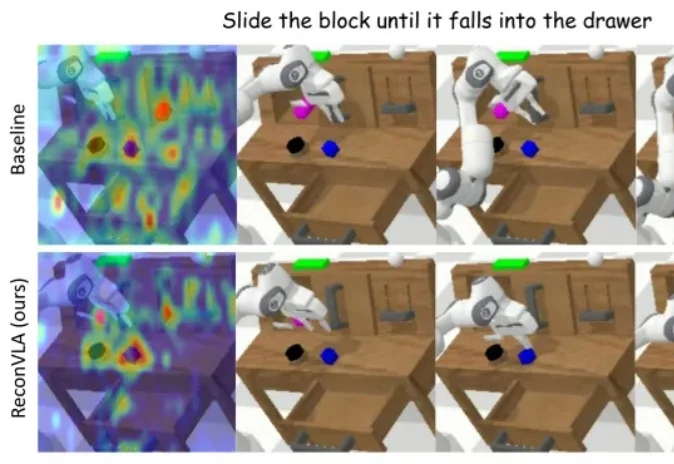

AAAI 2026杰出论文奖 | ReconVLA:具身智能研究首次获得AI顶级会议最佳论文奖

AAAI 2026杰出论文奖 | ReconVLA:具身智能研究首次获得AI顶级会议最佳论文奖在长期以来的 AI 研究版图中,具身智能虽然在机器人操作、自动化系统与现实应用中至关重要,却常被视为「系统工程驱动」的研究方向,鲜少被认为能够在 AI 核心建模范式上产生决定性影响。

在长期以来的 AI 研究版图中,具身智能虽然在机器人操作、自动化系统与现实应用中至关重要,却常被视为「系统工程驱动」的研究方向,鲜少被认为能够在 AI 核心建模范式上产生决定性影响。

如果没有PhD,是不是就和前沿AI研究没关系了?至少在Noam Brown看来,未必。这位OpenAI 研究员、o1的核心贡献者,刚刚分享了一串“非典型研究员”的经历。

由三位前 OpenAI 研究人员创立的初创公司 Applied Compute 正就以 13 亿美元估值筹集新资金进行谈判,包括该项投资在内。据透露,该公司致力于帮助企业使用自有数据定制模型。若融资成功,其估值将较不到三个月前公布的上一轮融资( 估值约 5 亿美元 )增长逾一倍。

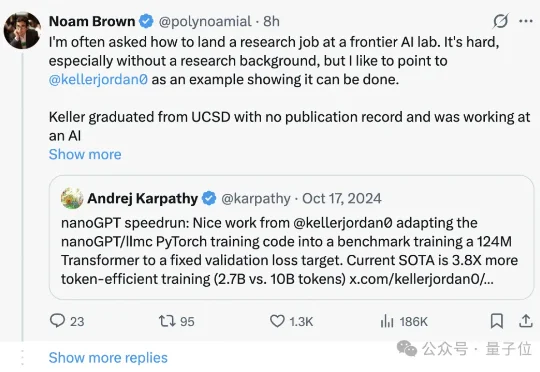

近日,美国华盛顿大学博士生邵如琳和合作团队打造出一个名为 Deep Research Tulu(DR Tulu)的深度研究小助手。使用一次 OpenAI 的 Deep Research 服务可能需要大约 1.8 美元,而 DR Tulu 使用一次的成本却不到 0.002 美元,这几乎是千倍的效率提升,这意味着未来个人或者小团队也能负担得起高质量、高可信度的 AI 研究服务。

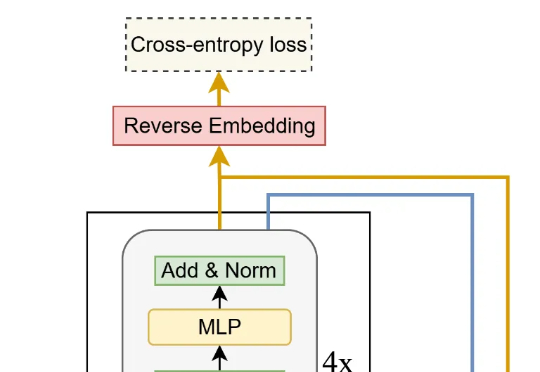

12 月 1 日,DeepSeek 一口气发布了两款新模型:DeepSeek-V3.2 和 DeepSeek-V3.2-Speciale。几天过去,热度依旧不减,解读其技术报告的博客也正在不断涌现。知名 AI 研究者和博主 Sebastian Raschka 发布这篇深度博客尤其值得一读,其详细梳理了 DeepSeek V3 到 V3.2 的进化历程。

一个研究者一天到底要读多少篇论文才能跟上最新趋势?在 AI 研究成果爆炸的今天,这个数字变得越来越模糊。人的阅读速度,早就跟不上 AI 科研地图扩展的速度了。

在这个新访谈中,Sutton 与多位专家一起,进一步探讨 AI 研究领域存在的具体问题。

来自加拿大蒙特利尔三星先进技术研究所(SAIT)的高级 AI 研究员 Alexia Jolicoeur-Martineau 介绍了微型递归模型(TRM)。这个 TRM 有多离谱呢?一个仅包含 700 万个参数(比 HRM 还要小 4 倍)的网络,在某些最困难的推理基准测试中,

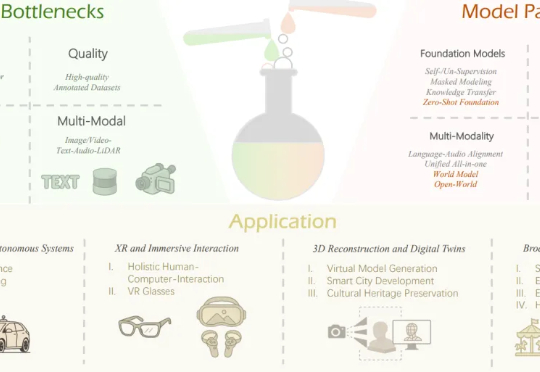

本文作者团队来自 Insta360 影石研究院及其合作高校。目前,Insta360 正在面向世界模型、多模态大模型、生成式模型等前沿方向招聘实习生与全职算法工程师,欢迎有志于前沿 AI 研究与落地的同

很多人相信,我们已经进入了所谓的「AI 下半场」,一个模型能力足够强大、应用理应爆发的时代。然而,对于这个时代真正缺少的东西,不同的人有不同的侧重,比如(前)OpenAI 研究者姚顺雨强调了评估的重要性,著名数学家陶哲轩则指出必须降低成本才能实现规模化应用。